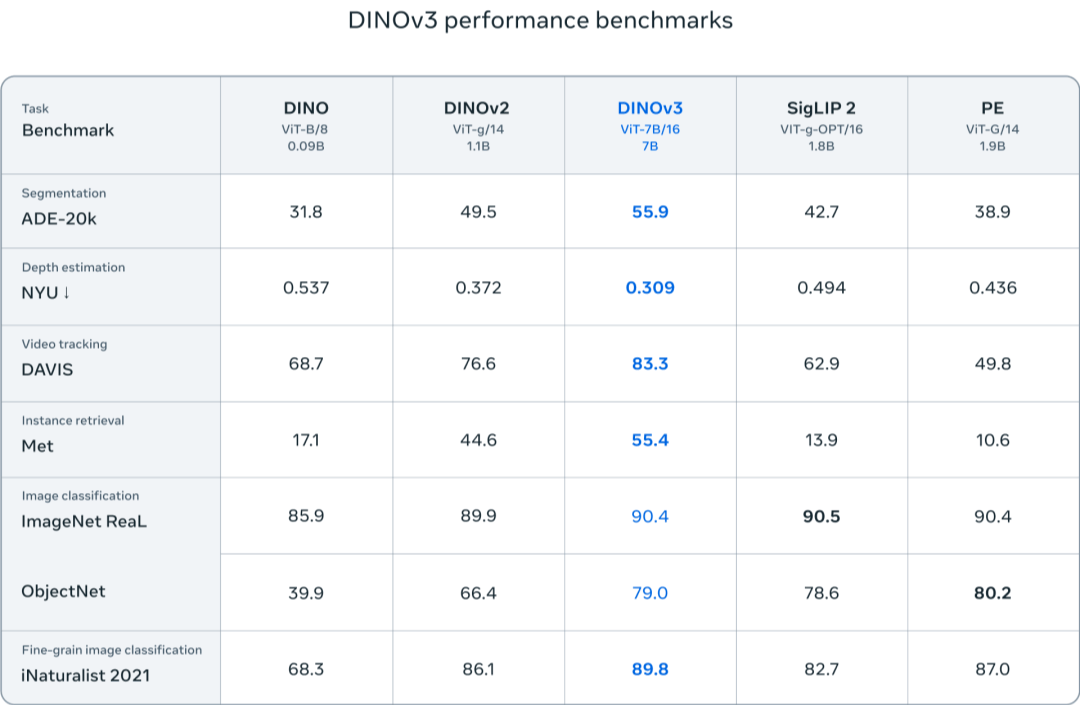

近期,上海交通大学与AI Infra领域的创新企业魔形智能携手,在国际高性能计算机架构研讨会HPCA 2025上发表了一篇题为《VQ-LLM: 高性能向量量化增强的大语言模型推理代码生成》的论文。该研究提出了一种名为VQ-LLM的框架,通过引入分层代码本缓存和代码本中心计算引擎两大创新技术,实现了超过50%的推理延迟降低,性能超越了传统逐元素量化方法。

VQ-LLM框架的成功,为向量量化技术在大语言模型中的实际应用提供了切实可行的方案。在保持模型高精度的同时,显著提升了推理效率。这一突破不仅解决了大模型计算量大、存储空间需求高的难题,还为向量量化技术的未来发展开辟了新的道路。

上海交通大学计算机科学与工程系教授冷静文是此次论文工作的主要负责人。冷静文教授自2010年从上海交通大学获得学士学位后,于2016年在德州大学奥斯汀分校获得电子与计算机工程系博士学位,专攻GPU处理器体系结构优化。目前,冷静文教授及其团队的研究兴趣集中在芯片架构和硬件互联方面,特别是数据流芯片设计和超节点高速互联域的硬件设计。

在谈到此次与魔形智能的合作时,冷静文教授表示,大模型压缩是当前热门的研究方向,但传统的单元素量化方法存在局限性。向量量化技术通过挖掘元素间的相关性,能够实现更高效的压缩,同时保持模型的精度。此次合作将向量量化技术应用于大语言模型,取得了显著的成果。

冷静文教授还分享了团队在数据流芯片研究方面的进展。他认为,当前GPU的红利已经接近尾声,未来芯片的架构和编程方法需要新的思考。数据流芯片作为一种创新的架构,有望解决当前芯片设计中的一些瓶颈问题。冷静文教授及其团队正在致力于构建数据流芯片的抽象模型和编程语言,以降低学习成本并推动其广泛应用。

在谈到国产芯片的发展时,冷静文教授表示,国产芯片厂商需要摆脱对英伟达等国外厂商的依赖,进行原创性思考。他认为,国产芯片厂商应该注重生态的构建,同时解决高带宽内存设计等问题。冷静文教授还提到了英伟达H20芯片出口受限对国内的影响,并建议国内芯片厂商考虑采用CXL互联方式或3D堆叠芯片等技术来缓解HBM的需求。

冷静文教授还分享了团队在大型模型优化方面的经验。他认为,系统的优化方法可以指导大模型的设计,特别是需要找到系统当前的瓶颈并结合模型的特点进行联合设计。冷静文教授还提到了NSA等前沿工作,认为这些工作为模型设计带来了新的思考,即将效率优先的原则带入到模型结构中去。

在谈到向量量化技术的未来应用时,冷静文教授表示,目前向量量化主要用于推理阶段,但未来可以考虑将其与训练过程相结合,以实现更高效的模型压缩和加速。冷静文教授还提到了DeepSeek等前沿工作对大模型量化的挑战和机遇,认为这些工作为向量量化技术提供了新的思路和方法。

冷静文教授及其团队的研究成果不仅在学术界引起了广泛关注,也在行业内产生了深远影响。目前,论文中提出的VQ-LLM框架已经正在被相关产品所采用,为推动大语言模型的广泛应用和性能提升做出了重要贡献。

冷静文教授还强调了芯片、系统和模型厂商之间的协同合作对于推动大模型进一步发展的重要性。他认为,在新的模型架构设计、模型小型化和轻量化等方面,芯片、系统和模型厂商可以发挥各自所长,共同推动大模型的广泛应用和性能提升。